AI正改变着各行各业,从内容创作到客户服务、知识问答等AI的应用日益广泛。为了更有效的利用AI,通常需要构建智能体或其初级形式的workflow。但在目前阶段无论是智能体亦或许Workflow都无法保证其自动运行能达到100%的可靠性,根源在于大模型存在着下面的一些问题:幻觉问题、工具调用的可靠性、训练数据未覆盖等。在引入RAG知识库后也未能够完全杜绝上面所说的问题。

既然AI自动化不能够100%保证可靠性,如果人在某个阶段介入进去是不是就会一定程度上提高其可靠性,这也就是人机协作。通过在Workflow或智能体(Agent)某些阶段要求人为介入进行审核或调整从改变智能体执行流程或改变其内容,将在一定程度上提高其可用性。

下面将通过理论、HITL在workflow应用模式以及一个内容生成的应用中介绍HITL在AI工作流的使用示例。

HITL(人在环中)

HITL(Human-in-the-Loop)人在环中 ,将人类引入智能体的关键节点从而达到人机协同的闭环。引入HITL的具体原因如下:

1、风险控制: 人作为最终的决策守门员

2、知识补充校正: 提供领域知识弥补AI知识盲区

3、驱动模型迭代进化

在不同阶段都可引入HITL,在模型训练阶段可以引入HITL对进行数据标注、校正偏见,在执行阶段通过HITL进行输出审核,在决策阶段通过HITL进行风险控制。

HITL最终能达到的作用包括如下:

1、抑制幻觉与错误: 通过专家介入纠正模型幻觉

2、责任清晰化: 如医疗诊断书的签署、法律文书的生成都需要人工去做决策

3、提升信任度: 流程的关键节点都是有专家参与监督的,而不是完全自动化的

HITL应用

在这里主要介绍在Workflow中引入HITL对工作流的某些节点输出进行一定程度的干预。HITL在workFLow中的具体实现也会根据业务性质有所不同,这里只简单介绍三种比较简单的HITL应用模式。

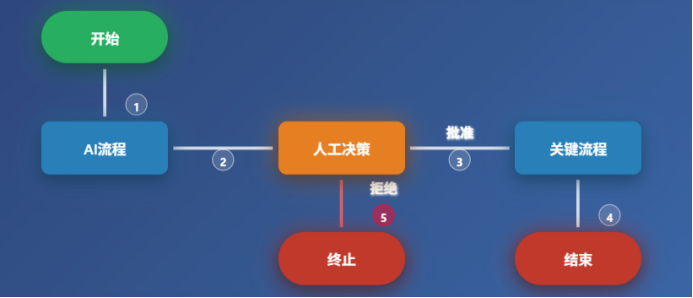

1、在关键流程前插入人工决策节点

在关键业务流程执行前插入人工决策节点,由领域专家人员决定是否继续执行后续流程或重新开始执行,适用于高风险操作如金融交易、医疗诊断等场景。

2、对关键输出后插入人工审核节点

在workflow工作流的某个关键节点后加入人工审核环节,确保结果准确性,适用于内容生成、文档处理、法律文书生成等质量敏感场景。

3、在节点输出置信度低于某个阈值时请求人工介入

在workflow工作流中加入置信度检测节点当置信度低于设定阈值时自动请求人工介入,平衡效率与准确性,适用于客服系统、图像识别等AI不确定性较高的场景。

当然上面只是三个比较简单HITL应用模型,实际场景中应用HITL可能需要详细分析workflow流程才能确定哪个环节需要人工的介入。

基于HITL的文章生成工作流

如下的流程图画出了AI辅助文章撰写的全流程,包括主题定义、大纲生成、初稿撰写、人工审核及最终润色优化,其中初稿审核也就是我们本文所说的HITL,也就是人工介入的节点。

这里的文章撰写智能体在用户提供主题后生成大纲、接着编写文章初稿后提示审核或编辑草稿,后再进行风格优化后生成最终文章。这里只在草稿生成后提供了人工介入,只要需要也可以在大纲编写完成后就进行人工介入,对大纲不满意可以打回让模型再生成一次大纲。

也有人会认为人为介入多了这还算是人工智能?在目前阶段有些AI工作流/智能体应用如果你对质量、可靠性要求非常高就很难做到得完全的0介入。按照自动驾驶的分级来看Agent目前也只是处于L2级别的Agent,距离L3级别Agent还有相当长一段时间。当前汽车也只是辅助驾驶,也做不到完全0介入,国内无驾驶员的示范运营区后台也有着人工在出现问题时介入。